Arquitectura de eventos y LLMs: ¿qué tan eficaz es esta combinación?

Arquitectura basada en eventos: el motor oculto de los sistemas modernos

En un mundo donde los datos fluyen de manera constante y las organizaciones necesitan reaccionar en milisegundos, la arquitectura basada en eventos (EDA, por sus siglas en inglés) se ha consolidado como un enfoque clave en el diseño de sistemas modernos, cada vez más utilizada en entornos distribuidos. Su aplicación en procesos que involucran modelos de lenguaje grande (LLMs) abre un abanico de oportunidades, pero también trae consigo ciertos desafíos que conviene evaluar.

¿Qué es la arquitectura de eventos?

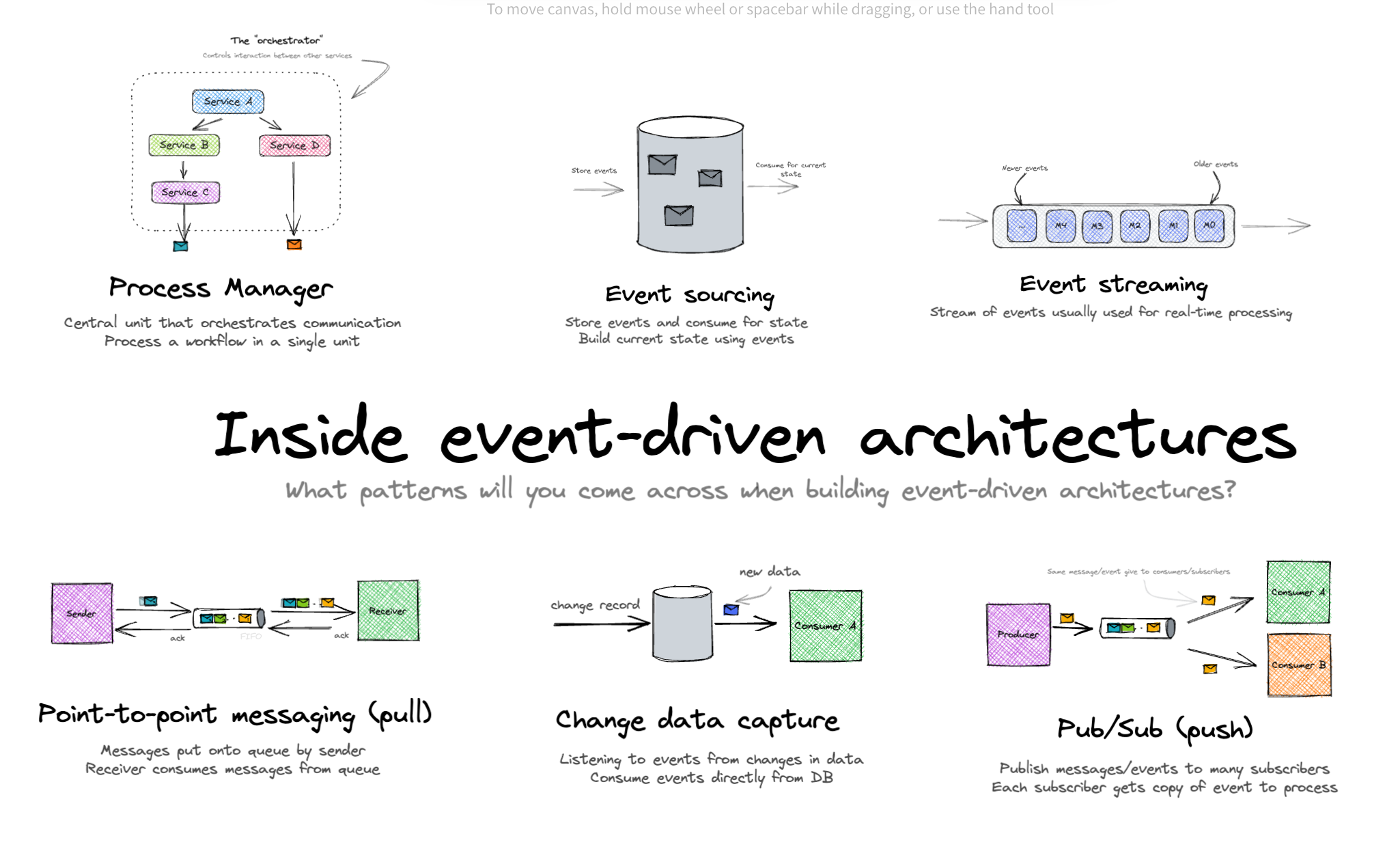

A diferencia del modelo tradicional request/response, en el que un servicio solicita algo a otro y espera una respuesta inmediata, la arquitectura de eventos se centra en la generación y el consumo de sucesos relevantes. Cuando ocurre algo significativo —como la creación de un pedido, la confirmación de un pago o el registro de un usuario—, se emite un evento. Otros servicios, actuando como suscriptores, reaccionan de forma independiente sin que el productor necesite conocerlos.

Ventajas principales

-

Desacoplamiento: los productores no dependen de qué servicios procesarán sus eventos.

-

Escalabilidad: permite gestionar grandes volúmenes de datos en tiempo real.

-

Flexibilidad: facilita la incorporación de nuevos servicios que reaccionen a eventos ya existentes.

-

Resiliencia: un fallo en un consumidor no afecta al productor, y con la ayuda de brokers o colas los procesos pueden reintentar su ejecución.

Retos a considerar

-

Complejidad en el diseño y monitoreo: los flujos son asincrónicos y no siempre lineales, lo que dificulta la depuración.

-

Garantías de entrega: se debe decidir entre políticas como “al menos una vez”, “exactamente una vez” o “como mucho una vez”.

-

Consistencia eventual: los datos no se sincronizan al instante, lo que exige un cambio de mentalidad frente a arquitecturas transaccionales más rígidas.

Comparativa con el modelo request/response

El enfoque tradicional basado en peticiones y respuestas (ejemplo típico: REST) resulta sencillo, directo y con una trazabilidad clara, lo que lo convierte en una buena opción para operaciones puntuales y sincrónicas, como la autenticación de un usuario o la consulta de un perfil. Sin embargo, está limitado por su fuerte acoplamiento y menor tolerancia a fallos.

La arquitectura de eventos, en cambio, brilla en escenarios distribuidos con múltiples microservicios, en entornos de IoT, e-commerce o plataformas financieras donde el procesamiento en tiempo real es crítico. Su capacidad para escalar y adaptarse la convierte en la elección natural cuando el objetivo es la agilidad.

¿Cuál elegir?

No se trata de descartar uno en favor del otro, sino de combinarlos de manera estratégica. Mientras que request/response es ideal para operaciones sincrónicas que requieren respuesta inmediata, los eventos permiten orquestar procesos complejos y asincrónicos, garantizando que los sistemas puedan crecer y responder con rapidez a las necesidades del negocio.

En definitiva, la clave está en entender las fortalezas de cada enfoque y utilizarlos como piezas complementarias en la construcción de arquitecturas modernas.

Integrando LLMs en arquitecturas basadas en eventos

La irrupción de los modelos de lenguaje de gran escala (LLMs) como no podía ser de otra manera, abre nuevas posibilidades en este paradigma. Integrados dentro de una arquitectura EDA, estos modelos actúan como consumidores inteligentes capaces de enriquecer datos en tiempo real, automatizar decisiones complejas o generar respuestas contextualizadas de forma asíncrona. Desde análisis de flujos en plataformas financieras hasta personalización instantánea en e-commerce, los LLMs se convierten en piezas clave que potencian la capacidad de reacción y aportan un nivel superior de resolución en los sistemas distribuidos.

Ventajas principales

Asincronía natural Las inferencias de LLM no son instantáneas. Con EDA se evita bloquear el sistema: un productor publica el evento de “solicitud de inferencia” y el consumidor lo procesa cuando el LLM responde.

Escalabilidad Los brokers de eventos permiten absorber picos de carga y distribuir peticiones entre múltiples consumidores, facilitando la escalabilidad horizontal.

Desacoplamiento El servicio que necesita una inferencia no tiene que conocer cómo está implementado el LLM ni su capacidad. Solo emite un evento y espera el resultado.

Pipelines modulares EDA permite encadenar etapas de forma flexible: preprocesamiento → recuperación de contexto (RAG) → inferencia con LLM → postprocesado → notificación al cliente.

Resiliencia Si un consumidor falla, el evento puede reintentarse o redirigirse a una cola de errores sin detener todo el flujo.

Actualizaciones en tiempo real En arquitecturas con RAG, los cambios en las fuentes de datos se pueden propagar de inmediato a través de eventos hacia el índice vectorial que alimenta al LLM.

Orquestación adaptativa Cuando intervienen múltiples agentes y tareas auxiliares, la coordinación basada en eventos permite flujos más dinámicos que los modelos rígidos request/response.

Retos y limitaciones

Latencia y consistencia Garantizar el orden y la coherencia de los eventos en flujos complejos no es trivial.

Complejidad operativa EDA requiere infraestructura de colas, monitoreo, trazabilidad y gobernanza del ciclo de vida de los eventos.

Gestión del estado Los LLMs necesitan contexto. Mantener memoria compartida entre componentes distribuidos es un reto.

Errores y compensaciones Si falla una etapa, hay que definir mecanismos de reintento y compensación para mantener la integridad del flujo.

Evolución de esquemas Los cambios en la estructura de los eventos deben gestionarse con versiones compatibles para no romper consumidores.

Sobrecarga de mensajería Si los eventos son demasiado granulares, la infraestructura puede saturarse con overhead en lugar de trabajo útil.

Reproducibilidad Depurar y auditar procesos distribuidos por eventos puede ser complejo.

Latencia acumulada Cada etapa añade su propia espera, lo que puede alargar los tiempos de respuesta.

¿Qué tan eficaz es en la práctica?

- En aplicaciones con múltiples etapas, agentes colaborativos o enriquecimiento de datos, la EDA es altamente eficaz.

- En casos simples (una sola llamada al LLM con respuesta inmediata), puede ser sobreingeniería.

- En entornos de alta concurrencia o tráfico variable, EDA ayuda a controlar la carga y evitar cuellos de botella.

- En aplicaciones que requieren memoria compartida o contexto persistente, es clave diseñar un buen manejo del estado.

Recomendaciones

- Define eventos con sentido semántico, evitando la excesiva granularidad.

- Centraliza el estado en stores externos para mantener coherencia.

- Incluye metadatos de trazabilidad en todos los eventos.

- Usa formatos de esquema versionados y compatibles.

- Diseña rutas de error claras con reintentos y colas de respaldo.

- Aplica backpressure para controlar la carga y proteger al LLM.

- Combina EDA con orquestación central cuando el flujo requiera coordinación estricta.

La arquitectura de eventos potencia la eficacia de los LLM en escenarios complejos y dinámicos. La clave está en equilibrar la flexibilidad con una gestión cuidadosa de la complejidad, el estado y la trazabilidad.